L’intelligence artificielle crée de nouvelles opportunités pour lutter contre la fraude

par Taka Ariga, Chief Data Scientist et directeur du laboratoire d’innovation du GAO, Johana Ayers, directeur général du service d’enquêtes et d’audits judiciaires (FAIS) du GAO, Toni Gillich, directeur adjoint du GAO FAIS, Nick Weeks, analyste principal du GAO FAIS, Scott Hiromoto, analyste principal des données de la recherche appliquée et des méthodes du GAO, et Martin Skorczynski, scientifique principal des données, laboratoire d’innovation du GAO.

La lutte contre les fraudeurs est depuis longtemps un défi persistant pour les entités gouvernementales. Bien qu’il n’y ait pas de chiffres précis, les activités frauduleuses drainent chaque année des milliards de dollars du contribuable au détriment de programmes vitaux. Dans le monde d’aujourd’hui, caractérisé par la connexion numérique et l’information, l’approche traditionnelle du travail de détection de la fraude, basée sur des examens rétrospectifs par les auditeurs, devient de plus en plus inefficace. Ce cadre “payez puis poursuivez” est gourmand en ressources, difficile à mettre à l’échelle et ne permet pas de récupérer un nombre significatif de transactions frauduleuses connues et suspectées.

Heureusement, la prolifération des données et les progrès des capacités informatiques ont ouvert l’âge d’or de l’intelligence artificielle (IA), où les algorithmes et les modèles peuvent révéler des schémas, des comportements et des relations anormaux – à une vitesse, à une échelle et à une profondeur qui n’étaient pas possibles il y a seulement dix ans.

De la navigation par le système de positionnement global à la reconnaissance faciale, l’IA a fondamentalement transformé tous les aspects de notre vie. De même, les organisations du secteur public tirent parti d’algorithmes puissants pour détecter et traiter de manière plus prospective les signaux d’alerte avant qu’ils ne se transforment en problèmes importants.

Il est important de noter que l’IA ne remplace pas le jugement professionnel des auditeurs expérimentés dans la détection d’activités potentiellement frauduleuses. Si l’IA peut passer au crible d’importants volumes de données avec une grande précision, l’intelligence humaine reste un élément essentiel pour déterminer les actions contextuelles, proportionnées et nuancées qui découlent des résultats algorithmiques. Cette relation symbiotique signifie que l’IA contribuera au travail des institutions supérieures de contrôle (ISC) et modifiera la manière dont ce travail est effectué – ce qui nécessitera des compétences différentes pour exploiter la capacité de l’IA à générer de l’efficacité et des gains d’efficience.

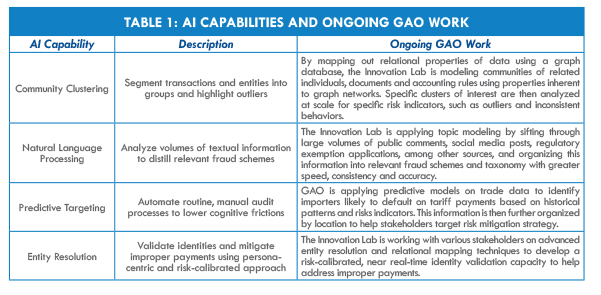

Le Government Accountability Office (GAO) des États-Unis cherche à tirer parti de la puissance de l’IA pour améliorer le contrôle du gouvernement et lutter contre la fraude, et le laboratoire d’innovation du GAO, créé en 2019 dans le cadre de la nouvelle unité Science, évaluation technologique et analytique de l’agence, favorise l’expérimentation de l’IA dans tous les cas d’utilisation de l’audit (voir le tableau 1 “Capacités d’IA et travaux en cours du GAO”).

Au fur et à mesure des progrès réalisés, le GAO entend partager les réussites et les enseignements tirés avec les ISC et l’ensemble de la communauté de la responsabilité. Parallèlement, le laboratoire d’innovation, en collaboration avec toutes les parties prenantes concernées, en est aux premiers stades de l’élaboration d’un cadre de surveillance de l’IA pour aider à guider le développement de solutions d’IA tout en adhérant aux bonnes pratiques et aux normes générales pour les auditeurs.

Le tableau 1 montre également comment le laboratoire d’innovation du GAO développe des capacités analytiques pertinentes en matière de fraude, qui pourraient constituer la base de futures solutions d’IA. Chaque cas d’utilisation est conçu pour identifier rapidement les corrélations cachées, les comportements, les relations, les modèles et les anomalies qui peuvent indiquer des risques de fraude.

Avant de mettre en œuvre des solutions analytiques d’IA pour le contrôle et la lutte contre la fraude, les ISC peuvent tirer profit de l’examen d’importantes considérations juridiques, sociétales, éthiques et opérationnelles qui sont particulièrement pertinentes pour l’IA. En outre, les ISC peuvent tirer des enseignements précieux des expériences et des leçons apprises par les organisations des secteurs privé et public.

CONSIDÉRATIONS IMPORTANTES LORS DE L’UTILISATION DE L’IA

Les algorithmes d’IA ne font pas la différence entre les transactions frauduleuses et non frauduleuses. Ces algorithmes identifient plutôt les anomalies, telles que des transactions inhabituelles entre des comptes. Des experts en la matière sont encore nécessaires pour analyser ces anomalies et déterminer s’il existe une fraude potentielle.

Pour résister à l’examen minutieux, les institutions d’audit qui souhaitent mettre en place des solutions d’IA anti-fraude peuvent prendre en compte une série de points de repère, notamment la manière dont les solutions d’IA sont conçues :

- Soigneusement formés et validés : Une formation et une validation rigoureuses des algorithmes d’IA sont nécessaires pour minimiser les erreurs du modèle. Les solutions d’IA qui génèrent un nombre excessif de faux positifs, par exemple en étiquetant trop de transactions légitimes comme potentiellement frauduleuses, peuvent submerger une organisation et sa capacité à enquêter sur des fraudes potentielles.Explicable,

- Logique et raisonnable : Les algorithmes d’IA explicables, bien définis et précisément documentés sont primordiaux. Il est important de s’assurer que les dépendances modélisées entre les variables sont logiques, que les hypothèses sous-jacentes sont raisonnables et que les résultats du modèle et de l’algorithme sont exprimés en langage clair.

- Auditable : Pour se conformer aux normes d’audit gouvernemental généralement acceptées, il est essentiel de documenter de manière approfondie les techniques d’IA appliquées. Cela inclut les paramètres liés aux modèles et aux ensembles de données utilisés, ainsi que la justification de l’inclusion de toute technique propriétaire, telle que les systèmes de tiers provenant de vendeurs externes.

- Gouverné : La surveillance des algorithmes d’IA est essentielle pour garantir des performances cohérentes dans différents environnements opérationnels. Il est impératif que les solutions d’IA, en particulier les algorithmes prêts à l’emploi, soient exemptes d’impacts négatifs, tels que la discrimination involontaire à l’encontre des groupes protégés.

ÉTAPES D’UNE MISE EN ŒUVRE RÉUSSIE DE L’AI

Les organisations des secteurs public et privé ont identifié plusieurs étapes clés pour la réussite des initiatives d’analyse de données, y compris les approches d’IA :

Identifier les objectifs et aligner les efforts : Il est recommandé d’identifier la manière dont les objectifs spécifiques du programme peuvent contribuer à répondre aux besoins de l’organisation dès les premières étapes de l’élaboration du programme d’analyse.

Obtenir l’adhésion : Le soutien de l’organisation à l’analyse des données et l’appréciation de sa capacité à améliorer la réalisation des objectifs sont essentiels. La création d’une division chargée de développer la capacité d’analyse est un moyen d’institutionnaliser les connaissances.

Comprendre les capacités actuelles : Dans un premier temps, les organisations peuvent dresser l’inventaire des ressources existantes afin de mieux comprendre les capacités et de hiérarchiser les domaines à améliorer. Les ressources clés comprennent l’expertise du personnel, le matériel et les logiciels, ainsi que les sources de données et les propriétaires.

Inclure les utilisateurs et les experts en la matière : L’intégration des experts en la matière dans les projets d’analyse peut contribuer à éclairer le développement du modèle et à obtenir l’adhésion des utilisateurs éventuels du modèle.

Commencer simplement, renforcer progressivement les capacités : Les organisations peuvent d’abord chercher à développer des solutions minimalement viables pour atteindre leurs objectifs. En identifiant et en obtenant des succès rapides et précoces, les organisations peuvent constituer un dossier pour développer progressivement d’autres capacités, créant ainsi une base pour la mise en œuvre de solutions d’IA plus sophistiquées.

Transition vers le fonctionnement : Une fois qu’un produit minimalement viable est développé, il est essentiel de le faire passer dans un environnement de production. Il est important de documenter les mises à jour de l’algorithme d’IA.

Les responsables des ISC peuvent envisager plusieurs ressources lorsqu’ils étudient la mise en œuvre de l’IA. Le cadre de référence du GAO sur les risques de fraude identifie les principales pratiques pour aider les gestionnaires de programmes à lutter contre la fraude financière et non financière. Ces pratiques de pointe comprennent des étapes pour utiliser les activités d’analyse de données afin de faciliter la détection des fraudes, ce qui peut aider à établir une base pour des analyses plus sophistiquées, telles que l’IA.

Le document du GAO intitulé “Highlights of a Forum : Data Analytics to Address Fraud and Improper Payments“, comprend des recommandations des secteurs public et privé sur la manière d’établir des programmes d’analyse. En particulier, les panélistes du forum ont fourni des suggestions sur l’établissement et le perfectionnement d’un programme d’analyse des données.

En 2018, le GAO a publié uneévaluation technologique de l’IAqui identifie une série d’opportunités, de défis et de domaines liés à l’IA devant faire l’objet de recherches futures et être pris en compte par les décideurs politiques.

Le groupe de travail de l ‘Organisation internationale des institutions supérieures de contrôle des finances publiques sur le Big Data contribue à faciliter le partage des connaissances entre les ISC sur les questions liées aux données et à l’analyse des données.

Experts en la matière interrogés

- Solon Angel, fondateur et directeur de l’impact, MindBridge Ai

- Jim Apger, architecte en sécurité, Splunk

- Bart Baesens, professeur de Big Data et d’analytique, Katholieke Universiteit Leuven, Belgique

- Justin Fessler, stratège en intelligence artificielle, IBM Federal

- Robert Han, Vice-président, Recherche sur les personnes âgées

- Bryan Jones, propriétaire et consultant principal, Strategy First Analytics

- Rachel Kirkham, responsable de la recherche sur l’analyse des données, Office national d’audit du Royaume-Uni (UKNAO)

- William Pratt, scientifique de données, UKNAO

- Wouter Verbeke, professeur associé d’informatique commerciale et d’analyse de données, Vrije Universiteit, Belgique